Poi arrivano i tribunali e rimettono le cose al loro posto.

A Torino, Sezione Lavoro, con la sentenza n. 2120 del 16 settembre 2025, viene contestata la redazione del ricorso introduttivo in larga parte con sistemi generativi, citazioni generiche, giurisprudenza fuori fuoco, assenza di vaglio critico.

Non è l’aneddoto folcloristico su “ChatGPT che sbaglia le sentenze”, come nel marzo scorso è accaduto in altro procedimento dinanzi al Tribunale di Firenze; è un ammonimento tecnico-giuridico, perchè la responsabilità professionale non si esternalizza all’algoritmo e, quando questo accade, le conseguenze possono determinare la condanna ex art. 96, co. 3, c.p.c. ovvero per responsabilità aggravata.

E ciò non perché l’IA sia “proibita”, ma perché l’affidamento cieco tradisce la diligenza.

A ruota giunge il Tribunale di Latina (Sezione Lavoro) che con la sentenza del 23 settembre 2025, conferma il sopra citato orientamento: atto “a stampone”, riconoscibile per impronta artificiale e per mancanza di controllo umano, con esito sanzionatorio analogo.

Le pronunce de quibus sono sufficienti per chiarire la regola di fondo secondo cui l’IA non deve sostituirsi al professionista.

Se abdichiamo al giudizio, non è la macchina a rispondere, siamo noi.

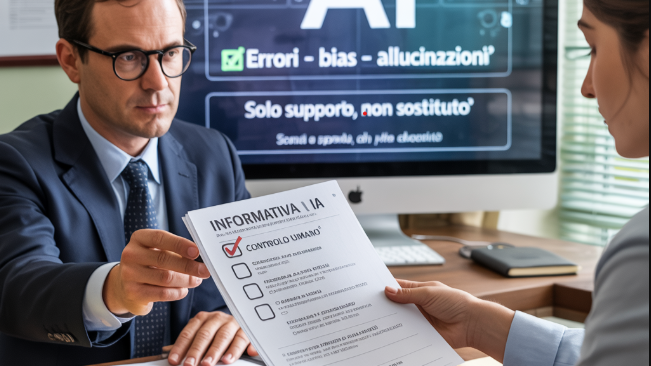

Ed intanto il quadro si completa facendosi anche normativo. La legge del 23 settembre 2025, n. 132 (che entrerà in vigore dal 10 ottobre p.v.) cristallizza quanto molti codici deontologici già suggerivano ovvero che l’uso dell’IA è lecito come supporto strumentale, non come surrogato dell’attività intellettuale; soprattutto, nasce l’ obbligo di informare il cliente, con linguaggio chiaro e comprensibile, prima o comunque contestualmente all’impiego di sistemi di IA nell’esecuzione dell’incarico. Non è una clausola di stile, ma un vincolo giuridico che si muove unitamente alla responsabilità contrattuale.

Qualcuno domanda se servisse davvero un’ “informativa IA”, posto che sussiste già una responsabilità di risultato.

Il legislatore italiano ha ritenuto di rispondere di sì.

E qui il diritto del lavoro fa da specchio. L’art. 1-bis del d.lgs. 152/1997, figlio del “Decreto Trasparenza”, impone da tempo comunicazioni rafforzate quando il datore usa sistemi decisionali o di monitoraggio automatizzati.

Con riguardo alla protezione dei dati, il GDPR interviene con prescrizioni direttamente applicabili. In presenza di dati personali, valgono gli artt. 13–14 (informativa), la valutazione d’impatto nei casi ad alto rischio, i limiti alle decisioni unicamente automatizzate.

Che cosa cambia, allora, nella pratica quotidiana?

Non l’ identità professionale, ma il modo in cui dovrà essere rendicontata.

Il professionista che userà l’IA dovrà darne comunicazione, precisando che il controllo resta umano, descrivendo gli eventuali rischi residui — errori, bias, allucinazioni — e le misure di mitigazione.

In conclusione, i provvedimenti di Torino e di Latina confermano che l’impiego dell’IA non esonera il professionista dal controllo e dalla responsabilità del metodo adottato. La legge 23 settembre 2025, n. 132, recepisce tale impostazione e la traduce in prescrizioni operative: utilizzare l’IA come strumento di supporto, informarne il cliente, garantirne il governo.

In simile prospettiva, la trasparenza è un requisito tecnico-organizzativo essenziale, funzionale all’efficienza ed alla responsabilità della prestazione.

Avv. Simona Maruccio

Giornalista pubblicista, opera da molti anni nel settore della compliance aziendale, del marketing e della comunicazione.